1.生成AI利用に潜むリスクとは

生成AI技術は飛躍的に進化しており、利用場面や用途が拡大する一方で生成AIに関連するトラブルも増えています。私たちは安全な利用方法についても考える必要があり、その第一歩として、まずは生成AIを利用する上でのリスクとその対策について学ぶことが重要です。生成AIを利用する上での課題の一例として、(1)入力情報の漏えいと、(2)生成AIの出力情報の不正確性が挙げられます。

(1)入力情報の漏えい

生成AIに入力した個人情報や機密情報といった秘匿すべき情報が意図せずAIの学習データに蓄積され、第三者が利用している際に出力されてしまうものです。

(2)出力情報の不正確性

生成AIは出力結果の内容の正しさまでは保証しません。生成AIの出力の妥当性を十分な検証をせず業務に活用した結果、誤った対応や情報発信をしてしまうと、企業の信用に悪影響を与える可能性があります。

これらのリスクは個人・企業問わず、利用者全員が抱えるものであり、適切な対策が求められます。

2.生成AIを安全に活用するには

まずはどのようなリスクや対策があるかを知ることで、検討できる対策の幅は広がり、その分だけ、より適切な対策を選択することができます。

対策と一言で言っても多種多様です。例えば、入力情報の漏えい対策としては、生成AIへの送信情報に対するチェック機能を導入し、入力データから個人情報が検知された場合はその場でデータを削除するといった対策があります。しかし、チェック機能自体に脆弱性があり検知をすり抜けて個人情報が漏洩してしまうことも考えられます。そのため、脆弱性を検知する機能や早急にパッチを適用できる運用体制もセットにすることが推奨されます。

このようにルールや体制構築などの「ガバナンス的対策」とシステム設定などの「システム的対策」の両方を取り入れることで、更なるリスク低減効果が見込まれます。言い方を変えれば、適切な対策を講じるには様々な「ガバナンス的対策」「システム的対策」を理解している必要があります。

3.リスク対策の勘所

ここでは【1.生成AI利用に潜むリスクとは】で述べた2つのセキュリティリスクを題材に、どのような対策があるかを、ガバナンス・システム両観点から検討します。

(1)入力情報の漏えいへの対策

入力情報の漏えいは生成AIの使用において最も懸念されるリスクのひとつです。特に企業にとっては顧客情報や機密情報が外部に流出することは大きな打撃となり得ます。引き起こされる原因は多種多様ですが、何らかの意図で引き起こされる計画的なものと、不十分なセキュリティ対策により発生する偶発的なものに大別できます。また、発生の起点が内部のものと外部のものにも大別できます。

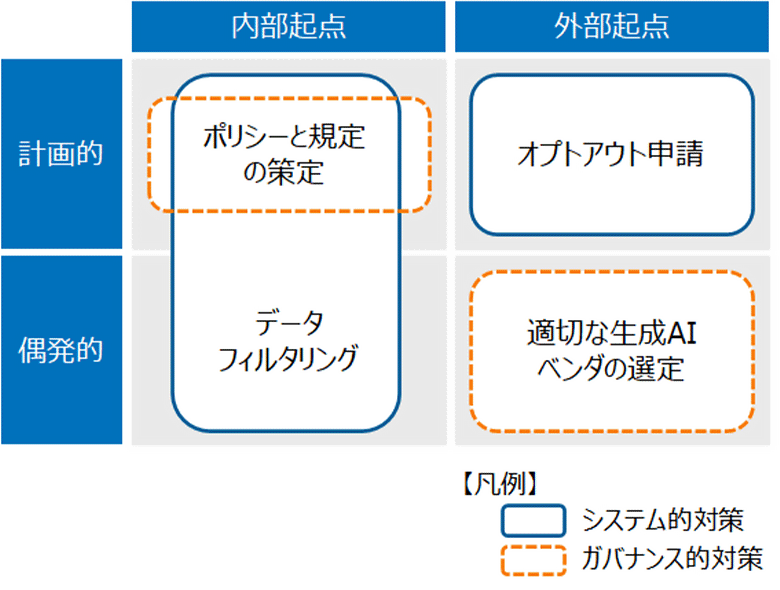

組み合わせごとのリスクと対策の例を以下に示します。

図:生成AIからの情報漏えいリスクと対策例

| システム的対策 | データフィルタリング | 生成AIに入力されるデータをリアルタイムでモニタリングし、機密情報が含まれる場合にその部分をマスキングまたは差し替える技術です。これにより、不適切な情報が生成AIを通じて外部に漏洩するリスクを低減できます。 |

| オプトアウト申請 | 利用者が入力したプロンプトに含まれる情報が生成AIに学習されないようにオプトアウトできる仕組みです。これにより、プロンプトに含まれている重要情報が、見ず知らずの第三者が同じ生成AIを利用している際に出力されてしまうリスクを低減します。 | |

| ガバナンス的対策 | ポリシーと規程の策定と徹底 | 企業全体で統一されたポリシーを策定し、生成AIの使用方法やデータ取り扱いのガイドラインを明確に定めます。ルールを策定しそれを従業員に徹底させることで、情報漏洩リスクを低減します。 |

| 適切な生成AIベンダーの選定 | どの生成AIを利用するか決める際には、第三者による継続的な監査を実施しているなど、ガバナンス的なセキュリティ対策を十全に行っているベンダーが提供する生成AIを採用します。これにより、不正アクセスやサイバー攻撃からのリスクなどを低減します。 |

表1:生成AIからの情報漏えいリスクと対策例

(2)出力情報の不正確性への対策

生成AIの活用にあたっては常に高品質な出力を得たいものです。不正確な情報発信は企業の信頼性を損ない、ビジネスに悪影響を及ぼす可能性があります。出力内容については生成AIの利用者が責任をもって実施することが原則ですが、リスク対策としては以下のようなものがあります。

| システム的対策 | 定期的にアップデートされている生成AIの選定 | 定期的にアップデートされ、常に最新版に保たれている生成AIを利用します。アップデートによりアルゴリズムの精度やパフォーマンスが改善されることもあるため、不正確な情報を出力するリスクを低減できます。 |

| 適切な機能を持った生成AIの選定 | クロスデリバレーションや、信頼度スコアリングといった、生成AIの出力内容の品質を担保するための技術を搭載している生成AIを選択します。これによって、不正確な情報を出力するリスクや、誤った情報を鵜呑みにするリスクを低減できます。 | |

| ガバナンス的対策 | ガイドライン制定 | 生成AIの利用に関するガイドラインを制定し、具体的な利用方法や注意点を明示します。このガイドラインにより、従業員は生成AIの機能や限界を理解し、適切に利用することができます。 |

| 従業員への教育 | 生成AIを正しく利用するためのトレーニングや、生成AI利用時のトラブル事例などの紹介を定期的に実施します。これにより、従業員一人一人の情報リテラシーを底上げするとともに、生成AIの回答を鵜呑みにして、そのまま社外へ発信してしまうようなリスクを低減します。 |

表2:出力情報の不正確性への対策例

4.おわりに

生成AIは昨今ではその言葉を聞かない日はないほど世の中に浸透している技術です。その活用についても今後ますます進むことが予想され、この流れは不可逆的であると言えます。反面、生成AIの利用を巡り様々なトラブルが発生しています。そういった背景の中で、生成AIを利用する際にはそのリスクと向き合い対策していくことが重要です。

本稿では、生成AIを利用する際の主要な2つのリスクについての対策方法について解説しました。しかし、本稿で触れた対策を講じたから終わりというわけではありません。その対策ではカバーしきれないリスクや、過剰に対策しているものがないかも考える必要があります。そのためには生成AIを取り巻くリスクを整理し、リスク毎の影響度や発生可能性に応じてリスクレベルを定め、そのリスクレベルに応じた適切な対策を取ることが求められます。

生成AI自体は比較的新しい技術であり、その進化もさらに加速していきます。また、生成AIは単体ではなく、様々なツールや情報システムと連携し、さらに影響力を増していくものと予測されます。リスクとその対策は日々更新されるため、適切なリスク対策を講じているとしても、生成AIに関わるセキュリティ動向のチェックとリスク対策の検討は欠かせません。NTT DATAでは、生成AIのセキュリティに関する研究開発やコンサルティング、導入支援を行っています。ご不安などがございましたら、ぜひご相談ください。

あわせて読みたい: