- 目次

1.サイバーセキュリティと、生成AIによる業務効率化

生成AIは、文章・画像・音声またはコード作成等、あらゆる分野で活用されています。ChatGPTやMicrosoft Copilot等を業務上の資料作成や議事録作成等に使用されている方も多いのではないでしょうか。

生成AIの業務活用には、正確さや精度に不安を感じられる方も多いと思いますが、大量のデータ・文章を圧倒的スピードで要約・翻訳できる等の得意なことも多く、生成AIの強みを活かした業務の自動化・効率化に注目が集まっています。もちろん同時に、生成AIを悪用した攻撃や、誤った利用による情報漏洩等リスクを論じられる場合もありますが、東京都が文書生成AIに関してガイドラインを公表する(※1)など、正しい利用を促す仕組みや環境の整備も進んできています。

サイバーセキュリティ運用についても、生成AIを活用した業務効率化が期待されています。脅威インテリジェンスの取得・活用、レポート作成等、生成AIが活用できる分野は幅広くあると考えられており、本記事では、生成AIがもたらす「サイバーセキュリティ運用における業務効率化」について焦点を当てて記述します。

2.生成AIをサイバーセキュリティの「インシデント対応業務」で使ってみよう!

今回は、その中でもサイバーセキュリティインシデント対応業務(以下、インシデント対応業務)に対して生成AIを使ってみた事例をご紹介します。インシデント対応業務は、過去の大量のデータをもとに、対応方針・対応方法を導き出す必要があります。この作業は大量のデータの中からの情報抽出・アイデア出しが得意な生成AIを活用しやすい業務だと考えられます。

NISTのサイバーセキュリティフレームワーク(NIST CSF)(※2)は、「識別」・「防御」・「検知」・「対応」・「復旧」の5フェーズに分かれます。サイバーセキュリティの脅威を「識別」し、「防御」および「検知」を行うところまでは、SIEMやEDR等の製品やサービスで対応することが多く、その製品自体の性能・設計/設定内容に依存する部分が大きいです。それらの製品が既にAI機能を有している事例も多くあります。それに対して「対応」・「復旧」のフェーズは、検知された内容を基に知見や人手を使って分析し、適切な対応・復旧手順を導き出す必要があります。人による対応力に大きく依存する業務は、生成AIによる業務効率化が期待できると考えられるため、今回は「対応」・「復旧」の2フェーズにおける業務について、生成AIを利用してみました。

図1:サイバーセキュリティフレームワーク(NIST CSF)におけるAI活用の検討

「対応」・「復旧」では、検知されたインシデント情報に対して、主に以下の情報を利用しながら分析・手順の精査を実施します。

(公開情報):インターネット上の公開情報(脆弱性情報や最新の脅威等)

(内部情報):社内情報(業務の内容、社員情報等)/インシデント対応マニュアル/過去のインシデント対応情報 等

上記は、データ量が莫大になるため、手作業で処理する場合には非常に時間が掛かります。実際の時間はインシデントの種類や社内情報の多さにも依存しますが、専任のメンバーであっても数日を要するケースもあります。

図2:一般的なインシデント対応/復旧の業務イメージ

そこで、それらの情報を生成AIに参照/学習させ、適切なインシデント対応/復旧が可能なのか試してみました。

図3:生成AIを使ったインシデント対応/復旧の業務イメージ

今回、公開情報の収集では、ChatGPTやCopilot等のSaaSを利用しました。それに対して機密性の高い情報を含む社内情報は、独自で環境構築が可能なAzure Open AI/Vertex AI等でセキュアな環境を構築し、その環境内で必要な情報を検索・分析を実施できるようにしました。この環境で、生成AIにインシデント対応業務における質問を行い、実際にどれほどインシデント対応・復旧フェーズで役に立つ情報が得られるのか試していきます。

3.プロンプトエンジニアリングの実施

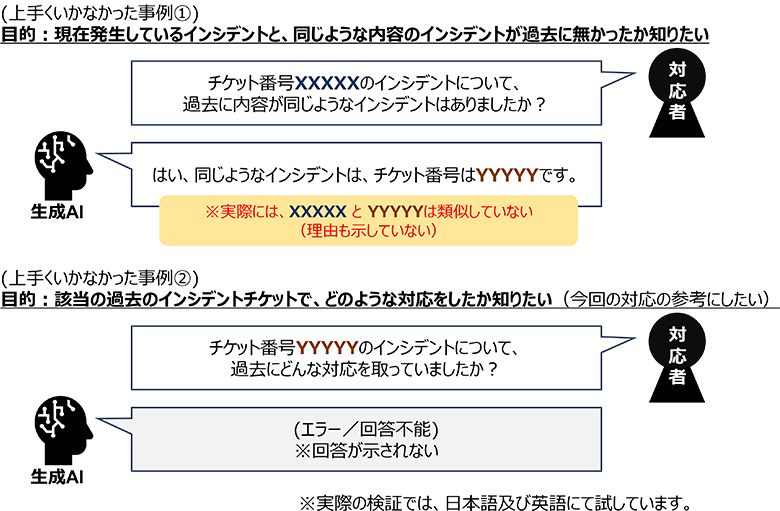

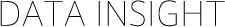

試験開始当初、適切な情報を正しく出力することもあれば、そうでない時もあるなど、回答の品質にバラつきがありました。この、正しい情報を返答してくれないパターンとしては、『誤った答えを教えてくれる』場合もあれば、『出力自体できずエラーになってしまう』場合もありました。

図4:上手くいかなかった事例

そこで、『プロンプトエンジニアリング』(※3)を実施しました。プロンプトエンジニアリングとは、生成AIに対する指示を詳細に構築、工夫することです。出力の品質を高めるために重要な作業の一つです。具体的には出力内容の粒度や文章の体裁等の指示等を行います。プロンプトエンジニアリングの手法として数多くのものが考案・研究されていますが、以下が今回の試験で効果の高かった手法の一例です。

図5:プロンプトエンジアリング例

これらの手法を用いて、生成AIへの指示内容をより具体的化させ、上記の『上手くいかなかった事例』で示したような「現在発生しているインシデントについて過去の事例から今回の対応についてアドバイスが欲しい」という目的でプロンプトを作成すると、以下のようになります。

図6:プロンプト例

これを実際にプロンプトを生成AIに出力させてみると、回答は以下のようになりました。

図7:上手くいった事例

このように、プロンプトエンジニアリングを駆使したことで、正確で順序立てて整理された回答を示すことができました。具体的な指示を与えることで、生成AIからの回答の品質を向上させ、対応者が欲しい情報を収集することが可能になったと言えます。

4.生成AIを利用することで得られた効果

上記より、必要な情報を生成AIに学習させ、適切な指示を与えることで、インシデント対応業務でも高い品質の回答を得られる可能性が示されました。このような、生成AIによる対応手順のアシストを受けられることで、これまで一人称で作業ができなかったような経験の浅い対応者であっても、高品質な対応ができるようになる等の効果が期待できます。

また業務工数の削減という面では、「手作業」の場合と比べ「生成AI」を活用した場合、平均で約25%の業務時間の削減が見込める結果となりました(本数値はインシデント対応業務実施者の経験やスキルにも依存するため、あくまでも参考値です。)これにより、セキュリティエンジニアはより多くのインシデント対応が可能になり、空き時間で、改善活動や後進育成等多忙で手が回りづらい業務にも着手できるようになると考えられます。

5.インシデント対応業務における生成AIの更なる可能性

生成AI活用の有効性は確認できた一方で、まだ回答の『正確性』や『柔軟性』の懸念を払しょくすることはできていません。今回の試験の中でも、生成AIの出力結果については、作業者による確認作業・検証は必須でした。また、生成AIに与えていない情報に関する質問をすると、回答の品質が著しく低下するという課題もあります。

未実証ですが、一つの可能性として、AIのモデル自体を変更させていく『ファインチューニング』と呼ばれる手法の適用が考えられます。生成AIのSaaSやPaaSで提供されている既存のモデルを使うのではなく、ファインチューニングによる情報の独自の解釈に基づく検証を進められれば、より精度が高くまたより応用的な回答を得られる可能性もあります。

今後、ファインチューニングに限らず、技術の進化により高品質なAIや多様なアプローチが期待されます。現在は、作業者の支援ツールとしての位置づけが強い生成AIですが、いずれは、業務の完全自動化や人に置き換わる時代がくるかもしれません。我々は引き続き、時代の流れに合わせ、最先端の技術を活かしたサイバーセキュリティ業務のご支援してまいります。

文章生成AI利活用ガイドライン:

https://www.digitalservice.metro.tokyo.lg.jp/documents/d/digitalservice/ai_guideline

The NIST CSF 2.0 has been released, along with other supplementary resources!:

https://www.nist.gov/cyberframework

Prompt Engineering Guide:

https://www.promptingguide.ai/jp

AI(人工知能):

https://www.nttdata.com/jp/ja/services/data-and-intelligence/governance/

あわせて読みたい: